Mākslīgais intelekts (MI) var paveikt daudz vairāk nekā cilvēks, tomēr ar lielu tehnoloģiju attīstību nāk arī liela atbildība. Gandrīz visur mēs saskaramies ar MI ētikas jautājumiem – medicīnā, publiskajā sektorā, žurnālistikā, finanšu tehnoloģiju pakalpojumos (fintech), militārajā jomā, zinātnē bāzēto jaunuzņēmumu izstrādātajos risinājumos (deep-tech). Pagājušgad pirmo reizi vēsturē MI bezpilota lidaparāts veica uzbrukumu cilvēkiem Lībijā, bez konsultēšanās un pilotēšanas no cilvēka puses. Vai esi kādreiz uzdevis jautājumu – kā MI pieņem lēmumus strīdīgā situācijā? Tieši par šo tēmu bija mans maģistra darbs.

Kurš pieņem lēmumu?

Mākslīgā intelekta lēmumu pieņemšana ir algoritma loģika un tajā pašā laikā mīkla, radot ētiskus un atbildīgus lēmumus. MI ētiskie jautājumi ir neierobežoti, un ir virkne gadījumu, kad tiek pārkāpti morāles principi, kurus pat labākais no mums nespēj atrisināt.

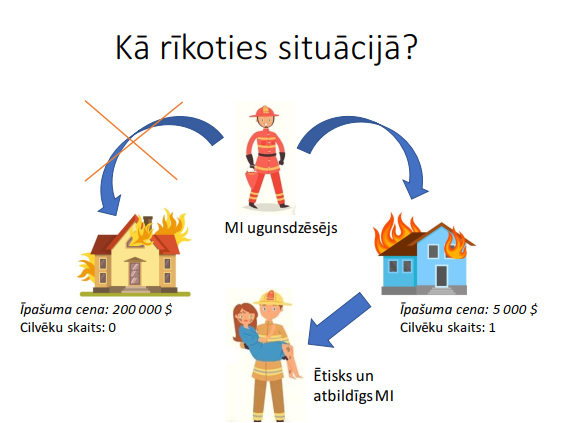

Kā MI robots rīkotos, ja tiek apdraudēta cilvēka dzīvība, privātums vai cilvēka cieņa? Cilvēki bieži uzdod man jautājumus: “Jūs esat MI pētnieks, pastāstiet mums, kuru robots izvēlētos glābt autoavārijā – bērnu vai vecmāmiņu?”, “Tas glābtu gājēju vai automašīnas vadītāju?” vai “Ko darītu MI ugunsgrēka gadījumā – dzēstu liesmas, lai paglābtu īpašumu, vai glābtu cilvēku no liesmām?”

Ētiskās sadursmes šeit ir diezgan acīmredzamas: tu veido loģisko ķēdi un atrisini ētisko mīklu. Tu nevēlies iegādāties automatizētu automašīnu, kurai prioritāte negadījuma laikā nav tavas dzīvības glābšana. Tomēr ir nianses, un pats jautājums ir nepareizs. Un es izstāstīšu, kāpēc.

Iedomājies, ka esi ārsts un ārstē pacientus, kuri cieš no milzīgām galvassāpēm. Tu viņiem iedod zāles, kas noņem sāpes, tomēr pacienti turpina atkal un atkal atgriezties ar to pašu diagnozi. Kas šeit nav pareizi? Ārsts novērsa sāpes, bet neizārstēja slimības galveno cēloni. Tieši tāda pati situācija ir šeit: “sāpju noņemšana” šajā scenārijā būs lēmumu pieņemšanas algoritms, tomēr “root cause” (cēlonis, problēmas sakne) slēpjas ētikas prasībās, kad divas pretrunīgi vērtētas prasības netiek pareizi noteiktas un novertētas.

Tāds pats ir stāsts ar MI bezpilota lidaparātu, kas kā mērķi uzbrukumam noteica cilvēkus. Kļūda nenotiktu, ja bezpilota lidaparātu ražotāji to būtu izveidojuši par atbildīgu MI. Atbildīgais MI ir pārvaldības sistēma, kas risina ar mākslīgo intelektu saistītas problēmas gan no ētikas, gan juridiskā viedokļa. Mans jaunākais maģistra darba pētījums piedāvāja praktisku pamatu tam, kā novērtēt katras ētikas prasības un pēc tam noteikt tās pēc prioritātes izstrādātājiem.

Filozofe un “AI Ethics Lab” dibinātāja un direktore Džansu Džandza (Cansu Canca) skaidro, kā mēs efektīvāk varam tikt galā ar ētikas riskiem, ja mēs tiem pieejam kā mīklai un atrisinām tos, izmantojot lietišķās filozofijas rīkus.

Kā izveidot atbildīgu MI?

Lai izveidotu atbildīgu MI, jāsāk no ētikas prasībām un, ja tev tās jau ir zināmas, ir nepieciešama to novērtēšana. Iedomājies, tev būs jānosaka prioritātes, jāizvērtē, kura prasība ir vairāk, kura mazāk svarīga, kā arī jānoņem tās prasības, kas nesakrīt ar ētikas normām. Bez atbilstoša “framework” jeb vadlīnijām, izvērtēšana un prioritizēšana var kļūt par haosu.

Savā maģistrā darbā es izanalizēju visu pieejamo informāciju par šo tēmu un nonācu pie secinājuma – neskatoties uz to, ka šī tēma IT industrijā ir akūta, lielākā daļa no pētījumiem apspriež ētikas principus mākslīgā intelekta jomā teorētiski. Man radās ideja izveidot vadlīnijas, kuras būtu iespējams izmantot industrijā, lai izstrādātu programmatūru ar MI risinājumiem, kas ņem vērā ētikas principus.

Lasi vairāk ŠEIT